Angesichts der rasanten Verbreitung von Kurzvideos, Online-Bildungsangeboten und Self-Media-Inhalten setzen immer mehr Produzenten auf automatisierte Untertitelungstools, um die Lesbarkeit der Inhalte und die Effizienz der Verbreitung zu verbessern. Doch wissen Sie wirklich: Welche KI generiert diese Untertitel? Wie genau, intelligent und welche Technologie steckt dahinter?

Als Content-Ersteller, der bereits verschiedene Untertitel-Tools verwendet hat, analysiere ich in diesem Artikel die Prinzipien, Kernmodelle, Anwendungsszenarien sowie Vor- und Nachteile der KI-Technologie zur Untertitelgenerierung anhand meiner eigenen Testerfahrungen. Wenn Sie Ihre Untertitel professioneller und präziser gestalten und die Ausgabe in mehreren Sprachen unterstützen möchten, bietet Ihnen dieser Artikel eine umfassende und praktische Antwort.

Inhaltsverzeichnis

Was ist Subtitle AI?

Mit der rasanten Entwicklung digitaler Videos ist die Untertitelerstellung längst nicht mehr auf mühsames manuelles Eintippen angewiesen. Die heutige Mainstream-Untertitelproduktion nutzt KI-gestützte Intelligenz. Was also ist KI für Untertitel? Welche Technologie wird dabei verwendet? Und welche gängigen Typen gibt es?

Bei der Untertitelgenerierung durch KI handelt es sich üblicherweise um ein intelligentes System, das auf den folgenden zwei Kerntechnologien basiert:

- ASR (Automatische Spracherkennung): wird verwendet, um Sprachinhalte in Video und Audio präzise in Text zu transkribieren.

- NLP (Natural Language Processing): wird verwendet, um Sätze aufzuteilen, Satzzeichen hinzuzufügen und die Sprachlogik zu optimieren, um die generierten Untertitel lesbarer und semantisch vollständiger zu machen.

Durch die Kombination dieser beiden Methoden kann KI automatisch erkennen Sprachinhalt → Untertiteltext synchron generieren → exakt am Timecode ausrichten. Dies ermöglicht die effiziente Generierung von Standarduntertiteln (z. B. .srt, .vtt usw.), ohne dass ein menschliches Diktat erforderlich ist.

Dies ist genau die Art von KI-Technologie für Untertitel, die häufig von globalen Plattformen wie YouTube, Netflix, Coursera, Tiktok usw. verwendet wird.

Drei Haupttypen von Untertitel-KI

| Typ | Repräsentative Tools/Technologien | Beschreibung |

|---|---|---|

| 1. Erkennungs-KI | OpenAI Whisper, Google Cloud Speech-to-Text | Konzentriert sich auf Sprache-zu-Text-Transkription, hohe Genauigkeit und mehrsprachige Unterstützung |

| 2. Übersetzungs-KI | DeepL, Google Übersetzer, Meta NLLB | Wird zum Übersetzen von Untertiteln in mehrere Sprachen verwendet und basiert auf dem Kontextverständnis |

| 3. Generierung + Bearbeitung von KI | Easysub (integrierter Multi-Modell-Ansatz) | Kombiniert Erkennung, Übersetzung und Zeitausrichtung mit bearbeitbarer Ausgabe; ideal für Inhaltsersteller |

Wie funktioniert KI für Untertitel?

Haben Sie sich schon einmal gefragt, wie KI Videoinhalte “versteht” und präzise Untertitel generiert? Tatsächlich ist der Prozess der Untertitel-KI-Generierung viel intelligenter und systematischer, als Sie denken. Es ist nicht einfach “Audio zu Text”, sondern eine Kombination aus KI-Subtechnologien, die schrittweise verarbeitet und Schicht für Schicht optimiert werden, um eine wirklich nutzbare, lesbare und exportierbare Untertiteldatei zu erstellen.

Nachfolgend erklären wir Ihnen detailliert den gesamten Prozess der automatische Untertitelgenerierung durch KI.

Schritt 1: Spracherkennung (ASR – Automatische Spracherkennung)

Dies ist der erste und wichtigste Schritt bei der Untertitelerstellung.Das KI-System nimmt die Spracheingabe aus dem Video oder Audio auf und analysiert sie mithilfe eines Deep-Learning-Modells, um den Textinhalt jedes Satzes zu erkennen. Gängige Technologien wie OpenAI Whisper und Google Speech-to-Text werden anhand umfangreicher mehrsprachiger Sprachdaten trainiert.

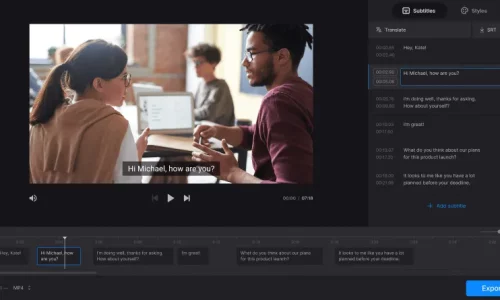

-1024x598.png)

Schritt 2: Natürliche Sprachverarbeitung (NLP)

KI kann Text erkennen, aber es handelt sich dabei oft um “Maschinensprache” ohne Zeichensetzung, ohne Satzumbrüche und mit schlechter Lesbarkeit.Die Aufgabe des NLP-Moduls besteht darin, eine linguistische Logikverarbeitung des erkannten Textes durchzuführen, einschließlich:

- Hinzufügen von Satzzeichen (Punkte, Kommas, Fragezeichen usw.)

- Aufteilen natürlicher Äußerungen (jeder Untertitel hat eine angemessene Länge und ist leicht zu lesen)

- Korrektur grammatikalischer Fehler zur Verbesserung der Sprachgewandtheit

Dieser Schritt wird normalerweise mit der Modellierung des Korpus- und kontextuellen semantischen Verständnisses kombiniert, um die Untertitel eher wie “menschliche Sätze”.

Schritt 3: Timecode-Ausrichtung

Untertitel sind nicht nur Text, sie müssen präzise mit dem Videoinhalt synchronisiert sein. In diesem Schritt analysiert die KI die Start- und Endzeiten der Rede, um Zeitleistendaten (Start-/End-Timecode) für jeden Untertitel zu generieren und so eine “Synchronisierung von Ton und Wort” zu erreichen.

Schritt 4: Ausgabe im Untertitelformat (zB SRT / VTT / ASS usw.)

Nach der Verarbeitung von Text und Timecode konvertiert das System den Untertitelinhalt in ein standardisiertes Format, das den Export, die Bearbeitung oder das Hochladen auf die Plattform erleichtert. Gängige Formate sind:

- .srt: gängiges Untertitelformat, das die meisten Videoplattformen unterstützt

- .vtt: für HTML5-Videos, unterstützt Webplayer

- .ass: unterstützt erweiterte Stile (Farbe, Schriftart, Position usw.)

💡 Easysub unterstützt den Export in mehreren Formaten, um die Anforderungen der Ersteller auf verschiedenen Plattformen wie YouTube, B-Station, TikTok usw. zu erfüllen.

Mainstream-Untertitelungs-KI-Technologiemodelle

Mit der Weiterentwicklung der Technologie für automatische Untertitelung entwickeln sich auch die dahinterstehenden KI-Modelle rasant weiter. Von Spracherkennung über Sprachverständnis bis hin zu Übersetzung und strukturierter Ausgabe haben etablierte Technologieunternehmen und KI-Labore mehrere hochentwickelte Modelle entwickelt.

Für Inhaltsersteller ist das Verständnis dieser Mainstream-Modelle hilfreich, um die technischen Stärken von Untertitelungstools zu bestimmen und die Plattform auszuwählen, die ihren Anforderungen am besten entspricht (wie Easysub).

| Modell / Werkzeug | Organisation | Kernfunktion | Anwendungsbeschreibung |

|---|---|---|---|

| Flüstern | OpenAI | Mehrsprachige ASR | Open-Source-Erkennung mit hoher Genauigkeit für mehrsprachige Untertitel |

| Google STT | Google Cloud | Spracherkennungs-API | Stabile Cloud-API, die in Untertitelsystemen auf Unternehmensebene verwendet wird |

| Meta NLLB | Meta-KI | Neuronale Übersetzung | Unterstützt über 200 Sprachen, geeignet für die Übersetzung von Untertiteln |

| DeepL Übersetzer | DeepL GmbH | Hochwertige MT | Natürliche, präzise Übersetzungen für professionelle Untertitel |

| Easysub AI Flow | Easysub (Ihre Marke) | End-to-End-Untertitel-KI | Integrierter ASR + NLP + Timecode + Übersetzung + Bearbeitungsablauf |

Herausforderungen und Lösungen für die KI-Technologie zur automatischen Untertitelung

Obwohl automatische Untertitelgenerierung Obwohl KI erstaunliche Fortschritte gemacht hat, steht sie in der praktischen Anwendung immer noch vor zahlreichen technischen Herausforderungen und Einschränkungen. Insbesondere bei mehrsprachigen, komplexen Inhalten, unterschiedlichen Akzenten oder lauten Videoumgebungen ist die Fähigkeit der KI, “zuzuhören, zu verstehen und zu schreiben”, nicht immer perfekt.

Als Content-Ersteller, der in der Praxis KI-Tools für Untertitel verwendet, habe ich einige typische Probleme bei deren Verwendung zusammengefasst und gleichzeitig untersucht, wie Tools und Plattformen, einschließlich Easysub, diese Herausforderungen bewältigen.

Herausforderung 1: Akzente, Dialekte und mehrdeutige Aussprache beeinträchtigen die Erkennungsgenauigkeit

Selbst mit modernsten Spracherkennungsmodellen können Untertitel aufgrund nicht standardisierter Aussprache, Dialektmischung oder Hintergrundgeräuschen falsch erkannt werden. Zu den häufigsten Phänomenen gehören:

- Englische Videos mit indischem, südostasiatischem oder afrikanischem Akzent können verwirrend sein.

- Chinesische Videos mit kantonesischem, taiwanesischem oder Szechuan-Dialekt fehlen teilweise.

- Laute Videoumgebungen (z. B. im Freien, bei Konferenzen, Live-Streaming) machen es der KI unmöglich, menschliche Stimmen genau zu unterscheiden.

Easysubs Lösung:

verwendet einen Fusionserkennungsalgorithmus mit mehreren Modellen (einschließlich Whisper und lokal selbst entwickelter Modelle). Verbessern Sie die Erkennungsgenauigkeit durch Spracherkennung + Hintergrundgeräuschunterdrückung + Kontextkompensationsmechanismus.

Herausforderung 2: Komplexe Sprachstrukturen führen zu unangemessenen Satzumbrüchen und schwer lesbaren Untertiteln.

Wenn dem von der KI transkribierten Text die Zeichensetzung und Strukturoptimierung fehlt, wirkt es oft so, als ob der ganze Absatz ohne Pausen aneinandergereiht wäre und sogar die Bedeutung des Satzes verloren geht. Dies beeinträchtigt das Verständnis des Publikums erheblich.

Easysubs Lösung:

Easysub verfügt über ein integriertes NLP-Modul (Natural Language Processing). Mithilfe eines vortrainierten Sprachmodells werden Sätze intelligent aufgeteilt, Zeichensetzungen vorgenommen und der Originaltext semantisch geglättet, um Untertiteltexte zu generieren, die besser zu den Lesegewohnheiten passen.

Herausforderung 3: Unzureichende Genauigkeit der mehrsprachigen Untertitelübersetzung

Beim Übersetzen von Untertiteln ins Englische, Japanische, Spanische usw. neigt KI aufgrund fehlenden Kontexts dazu, mechanische, steife und aus dem Kontext gerissene Sätze zu produzieren.

Easysubs Lösung:

Easysub lässt sich in das Multimodell-Übersetzungssystem DeepL/NLLB integrieren und ermöglicht Benutzern nach der Übersetzung ein manuelles Korrekturlesen und die Bearbeitung im mehrsprachigen Querverweismodus.

Herausforderung 4: Nicht harmonisierte Ausgabeformate

Einige Untertitel-Tools bieten nur eine einfache Textausgabe und können keine Standardformate wie .srt, .vtt oder .ass exportieren. Dies führt dazu, dass Benutzer Formate manuell konvertieren müssen, was die Effizienz der Nutzung beeinträchtigt.

Easysubs Lösung:

unterstützt den Export Untertiteldateien in mehreren Formaten und mit einem einzigen Klick zwischen Stilen wechseln, wodurch sichergestellt wird, dass Untertitel nahtlos auf allen Plattformen angewendet werden können.

-1024x351.png)

Welche Branchen eignen sich am besten für KI-Untertitelungstools?

KI-Tools für automatisierte Untertitelung sind nicht nur für YouTuber oder Videoblogger geeignet. Mit der zunehmenden Popularität und Globalisierung von Videoinhalten setzen immer mehr Branchen auf KI-Untertitelung, um die Effizienz zu steigern, das Publikum zu erreichen und die Professionalität zu verbessern.

- Aus- und Weiterbildung (Online-Kurse / Lehrvideos / Vorlesungsaufzeichnungen)

- Unternehmensinterne Kommunikation und Schulung (Besprechungsprotokolle / internes Schulungsvideo / Projektbericht)

- Kurzvideos aus Übersee und grenzüberschreitender E-Commerce-Content (YouTube / TikTok / Instagram)

- Medien- und Filmproduktionsbranche (Dokumentation / Interview / Postproduktion)

- Online-Bildungsplattform / SaaS-Tool-Entwickler (B2B-Inhalte + Produktdemovideos)

Warum empfehlen Sie Easysub und was unterscheidet es von anderen Untertitelungstools?

Es gibt zahlreiche Untertitel-Tools auf dem Markt, von der automatischen Untertitelung von YouTube über Plug-ins für professionelle Bearbeitungssoftware bis hin zu einigen einfachen Übersetzungshilfen … Aber viele Leute werden bei der Verwendung Folgendes feststellen:

- Bei manchen Tools ist die Erkennungsrate nicht hoch und die Sätze sind irgendwie fehlerhaft.

- Einige Tools können keine Untertiteldateien exportieren und können nicht zweimal verwendet werden.

- Einige Tools weisen eine schlechte Übersetzungsqualität auf und lassen sich nicht gut lesen.

- Einige Tools verfügen über komplexe und unfreundliche Schnittstellen, die für den durchschnittlichen Benutzer schwierig zu verwenden sind.

Als langjähriger Videoproduzent habe ich viele Untertitel-Tools getestet und mich schließlich für Easysub entschieden und es empfohlen. Denn es bietet die folgenden 4 Vorteile:

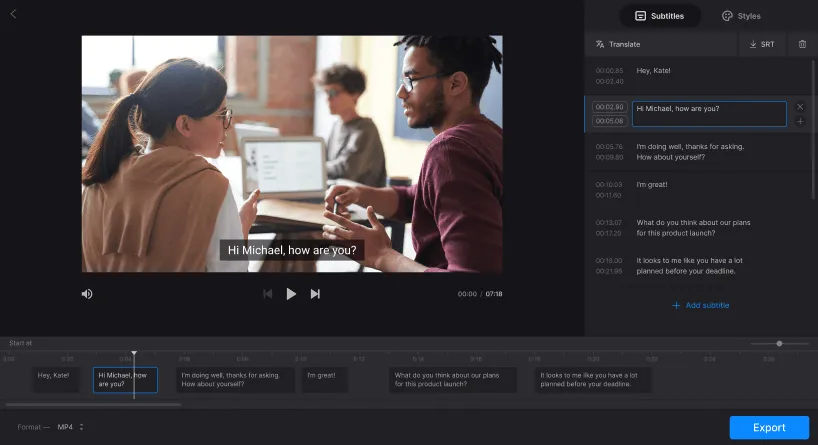

- Erkennt mehrsprachige Sprache präzise und passt sich an unterschiedliche Akzente und Kontexte an.

- Visueller Untertitel-Editor + manuelle Feinabstimmung, flexibel und steuerbar.

- Unterstützt Übersetzungen in über 30 Sprachen, geeignet für Benutzer im Ausland und mehrsprachige Benutzer.

- Umfassende Palette an Ausgabeformaten, kompatibel mit allen wichtigen Plattformen und Bearbeitungstools

| Funktionskategorie | Easysub | Automatische Untertitel auf YouTube | Manuelle Untertitelbearbeitung | Allgemeine KI-Untertiteltools |

|---|---|---|---|---|

| Genauigkeit der Spracherkennung | ✅ Hoch (mehrsprachige Unterstützung) | Mittel (Gut für Englisch) | Hängt vom Kenntnisstand ab | Durchschnitt |

| Übersetzungsunterstützung | ✅ Ja (über 30 Sprachen) | ❌ Nicht unterstützt | ❌ Manuelle Übersetzung | ✅ Teilweise |

| Untertitelbearbeitung | ✅ Visueller Editor & Feinabstimmung | ❌ Nicht editierbar | ✅ Volle Kontrolle | ❌ Schlechte Bearbeitungs-UX |

| Exportformate | ✅ SRT / VTT / Ass unterstützt | ❌ Kein Export | ✅ Flexibel | ❌ Begrenzte Formate |

| Benutzerfreundlichkeit der Benutzeroberfläche | ✅ Einfache, mehrsprachige Benutzeroberfläche | ✅ Sehr einfach | ❌ Komplexer Workflow | ❌ Oft nur auf Englisch |

| Chinesischer Inhalt freundlich | ✅ Hochgradig optimiert für CN | ⚠️ Verbesserungsbedürftig | ✅ Mit Mühe | ⚠️ Unnatürliche Übersetzung |

Nutzen Sie EasySub noch heute, um Ihre Videos zu verbessern

Im Zeitalter der Globalisierung von Inhalten und der explosionsartigen Zunahme von Kurzvideos ist die automatische Untertitelung zu einem wichtigen Instrument geworden, um die Sichtbarkeit, Zugänglichkeit und Professionalität von Videos zu verbessern.

Mit KI-Plattformen zur Untertitelgenerierung wie Easysub, Inhaltsersteller und Unternehmen können in kürzerer Zeit hochwertige, mehrsprachige und genau synchronisierte Videountertitel erstellen und so das Seherlebnis und die Vertriebseffizienz erheblich verbessern.

Im Zeitalter der Content-Globalisierung und der explosionsartigen Zunahme von Kurzvideos ist die automatische Untertitelung zu einem wichtigen Instrument geworden, um die Sichtbarkeit, Zugänglichkeit und Professionalität von Videos zu verbessern. Mit KI-basierten Untertitelungsplattformen wie Easysub können Content-Ersteller und Unternehmen in kürzerer Zeit hochwertige, mehrsprachige und präzise synchronisierte Videountertitel erstellen und so das Seherlebnis und die Vertriebseffizienz deutlich verbessern.

Egal, ob Sie Anfänger oder erfahrener Content-Ersteller sind – Easysub beschleunigt und optimiert Ihre Inhalte. Testen Sie Easysub jetzt kostenlos und erleben Sie die Effizienz und Intelligenz der KI-Untertitelung, mit der jedes Video ein globales Publikum über Sprachgrenzen hinweg erreicht!

Lassen Sie Ihre Inhalte in nur wenigen Minuten durch KI verbessern!

👉 Klicken Sie hier für eine kostenlose Testversion: easyssub.com

Danke, dass Sie diesen Blog lesen. Bei weiteren Fragen oder Anpassungswünschen können Sie uns gerne kontaktieren!