Lorsque la durée des vidéos passe de quelques minutes à une ou deux heures, la difficulté de la production de sous-titres augmente de façon exponentielle : volumes de texte plus importants à reconnaître, variations significatives du débit de parole, structures de phrases plus complexes et plus grande sensibilité aux décalages temporels. Par conséquent, un nombre croissant de créateurs, de concepteurs de cours et d’équipes de podcast recherchent une solution plus stable et plus précise : un système de sous-titrage automatique. Générateur de sous-titres IA pour les vidéos longues. Il doit non seulement traiter rapidement les fichiers volumineux, mais aussi garantir une synchronisation et une cohérence sémantique parfaites tout au long de la vidéo. Pour les utilisateurs souhaitant améliorer l'accessibilité du contenu, optimiser l'expérience de visionnage ou proposer des sous-titres pour un public multilingue, un flux de travail fiable de génération de sous-titres par IA ne se limite pas à un gain d'efficacité ; il s'agit avant tout de garantir la qualité du contenu.

Table des matières

Les vidéos longues nécessitent un générateur de sous-titres IA spécialisé

Les défis posés par la génération de sous-titres pour les vidéos longues sont totalement différents de ceux rencontrés pour les vidéos courtes. Premièrement, le contenu vocal des vidéos longues est plus complexe : plus la durée est longue, plus le débit, l’intonation et la clarté de la parole des intervenants sont susceptibles de varier. Cette ’ dérive vocale “ a un impact direct sur la précision de la reconnaissance par l’IA. Deuxièmement, les vidéos longues contiennent souvent de nombreux bruits de fond – comme le bruit des pages qui se tournent lors de cours, les bruits ambiants lors d’interviews ou les clics de clavier lors d’enregistrements de réunions – qui rendent tous l’analyse des signaux vocaux plus difficile. Parallèlement, la logique de la structure des phrases dans les vidéos longues est plus complexe à traiter : l’IA doit non seulement reconnaître le contenu, mais aussi identifier avec précision les frontières entre les phrases sur des dizaines de minutes, voire des heures d’audio. De plus, la qualité audio des vidéos longues est souvent inégale. Les sources comme Zoom, Teams ou les enregistrements de cours peuvent souffrir de niveaux de volume inégaux ou d’une compression audio excessive, ce qui complique encore davantage la reconnaissance.

Par conséquent, les outils de sous-titrage classiques rencontrent fréquemment des problèmes tels que des saccades, des mots omis, des retards, des décalages temporels, voire des plantages complets lors du traitement de vidéos de plus d'une heure. Tous les outils de sous-titrage par IA ne prennent pas en charge de manière fiable les vidéos de plus d'une heure. De nombreux utilisateurs recherchent donc des solutions spécifiquement optimisées pour les vidéos longues.

Facteurs clés importants pour les utilisateurs dans un générateur de sous-titres IA pour les vidéos longues

1. Exactitude des sous-titres

- Les erreurs s'accumulent dans les longues vidéos, ce qui augmente les coûts de relecture.

- L'accent, le bruit de fond, la qualité de l'enregistrement, les variations du débit de parole et la présence de plusieurs locuteurs ont tous un impact sur la précision de la reconnaissance.

- Les outils nécessitent des capacités plus performantes en matière de réduction du bruit, de segmentation des phrases et de compréhension contextuelle.

2. Délai de traitement

- Les utilisateurs s'attendent à ce que les vidéos d'une heure soient transcrites en 5 à 20 minutes.

- Un traitement lent ou des pannes dégradent directement l'expérience utilisateur.

- Des serveurs stables et des capacités d'inférence efficaces sont essentiels.

3. Compatibilité avec les vidéos longues

- Les outils gratuits sont souvent limités à 10-20 minutes, ce qui empêche le téléchargement des vidéos longues.

- Les utilisateurs ont besoin d'outils capables de traiter de manière fiable des vidéos de 1 à 3 heures, voire plus.

- Aucun plantage ni perte de contenu pendant le traitement.

4. Alignement chronologique

- Les vidéos longues sont plus sujettes aux retards ou aux avances des sous-titres.

- Les utilisateurs redoutent que les sous-titres soient “ précis dans la première moitié, mais erronés dans la seconde ”.”

- Les mécanismes d'alignement forcé et de correction de la chronologie améliorent la qualité de la synchronisation.

5. Sous-titres multilingues

- Les cours, les conférences et les entretiens nécessitent souvent des sous-titres multilingues.

- Les utilisateurs s'attendent à une traduction en un clic et à l'exportation de sous-titres bilingues.

- Les fonctionnalités multilingues constituent un atout majeur pour les outils de production vidéo longue durée.

6. Facilité de modification

- Les vidéos longues impliquent des volumes importants de sous-titres, ce qui rend la relecture fastidieuse.

- Les utilisateurs ont besoin de fonctionnalités telles que l'édition par lots, la division rapide des phrases et la fusion des lignes.

- Les logiciels de montage doivent être stables et sans latence pour optimiser l'efficacité de la post-production.

Comment fonctionnent les générateurs de sous-titres IA pour les vidéos longues

Pour générer des sous-titres pour une vidéo d'une à deux heures, l'IA doit suivre un processus technique plus complexe que pour les vidéos plus courtes. Les étapes suivantes garantissent non seulement la génération des sous-titres, mais aussi leur stabilité, leur précision et leur synchronisation tout au long de la vidéo.

a. Segmentation audio

Lors du traitement de vidéos longues, l'IA n'intègre pas l'intégralité du fichier audio au modèle en une seule fois. Cela risquerait d'entraîner des échecs de reconnaissance ou des délais d'attente du serveur en raison des limitations de taille des fichiers. Le système divise donc l'audio en segments plus courts, de quelques secondes à plusieurs dizaines de secondes, en fonction de leur signification ou de leur durée. Cette segmentation garantit une exécution stable de la tâche de reconnaissance et réduit la consommation de mémoire, permettant ainsi au modèle de fonctionner efficacement.

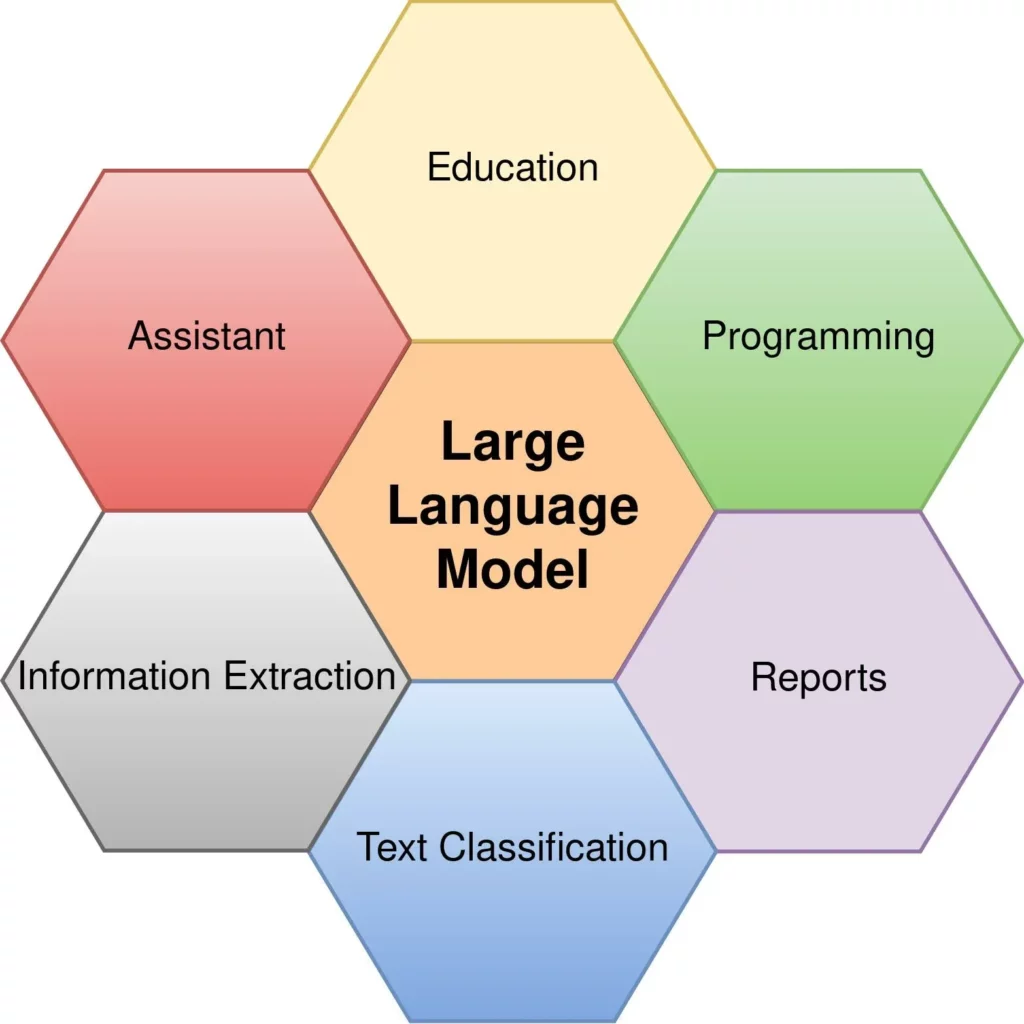

b. Modèle de reconnaissance vocale automatique (ASR)

Après la segmentation audio, l'IA passe à l'étape principale : la conversion de la parole en texte. Parmi les modèles standards du secteur figurent Transformer, wav2vec 2.0 et Whisper.

- Transformateur offre des performances stables dans les langues courantes comme l'anglais, tout en restant sensible aux variations d'accent.

- wav2vec 2.0 Elle excelle dans les environnements peu bruyants, ce qui la rend idéale pour les vidéos longues comme les cours magistraux et les interviews.

- Chuchoter Il offre une gestion supérieure du bruit de fond et une prise en charge multilingue, ce qui lui confère un avantage certain dans les scénarios vidéo prolongés.

Les différents modèles présentent des variations notables en termes de précision de reconnaissance pour les vidéos longues. Les modèles les plus avancés gèrent mieux les détails tels que les fluctuations du débit de parole, les pauses et les bruits mineurs.

Les sous-titres ne sont pas un texte continu, mais de courts segments délimités par leur sens. La segmentation des phrases est relativement simple pour les vidéos courtes, mais se complexifie pour les vidéos longues en raison des changements de ton, de la fatigue vocale et des transitions logiques. L'IA s'appuie sur les pauses, la structure sémantique et des modèles probabilistes pour déterminer quand couper les lignes ou fusionner les phrases. Une segmentation plus précise réduit le travail de post-production.

d. Alignement forcé

Même avec une reconnaissance de texte impeccable, les sous-titres peuvent être désynchronisés avec l'audio. Les vidéos longues sont particulièrement sujettes à ce problème de synchronisation, parfois précise au début mais décalée par la suite. Pour y remédier, l'IA utilise une technologie d'alignement forcé, faisant correspondre mot à mot le texte reconnu avec la piste audio. Ce processus fonctionne à la milliseconde près, garantissant ainsi une synchronisation parfaite des sous-titres tout au long de la vidéo.

e. Correction du modèle de langage

Les vidéos longues partagent une caractéristique commune : des liens contextuels forts. Par exemple, une conférence peut aborder à plusieurs reprises le même concept central. Afin d’améliorer la cohérence des sous-titres, l’IA utilise des modèles de langage pour une correction secondaire après la reconnaissance. Le modèle évalue si certains mots doivent être remplacés, fusionnés ou ajustés en fonction du contexte. Cette étape améliore considérablement la fluidité et le professionnalisme des sous-titres des vidéos longues.

EasySub, un générateur de sous-titres IA pour les vidéos longues

Pour la génération de sous-titres de vidéos longues, EasySub privilégie la stabilité et la maîtrise plutôt que la simple vitesse ou l'automatisation. Ses fonctionnalités garantissent des performances constantes lors du traitement de vidéos de 1 à 3 heures, ce qui le rend idéal pour les contenus longs tels que les cours, les interviews, les podcasts et les tutoriels.

Prise en charge de durées de traitement vidéo plus longues

EasySub gère efficacement les fichiers vidéo volumineux, prenant en charge des contenus d'une heure, de deux heures, voire plus. Qu'il s'agisse de cours enregistrés, de transcriptions de réunions ou d'entretiens longs, la reconnaissance se poursuit sans interruption ni dépassement de délai.

Vitesse de traitement à haute efficacité

Dans la plupart des cas, EasySub utilise un traitement parallèle basé sur la charge du serveur et des stratégies d'optimisation du modèle.

Une vidéo de 60 minutes génère généralement des sous-titres complets en 5 à 12 minutes. À cette vitesse, les vidéos longues conservent une grande stabilité et une qualité de sortie constante.

Optimisation multicouche pour la précision

Pour les vidéos longues, EasySub utilise plusieurs stratégies de reconnaissance et d'optimisation, notamment la reconnaissance vocale multilingue, une légère réduction automatique du bruit et un modèle de segmentation de phrases entraîné. Cette combinaison réduit les interférences dues au bruit de fond et améliore la précision de la reconnaissance pour les discours continus prolongés.

Expérience de montage simplifiée

Les sous-titres de vidéos longues nécessitent souvent une relecture manuelle. L'éditeur d'EasySub prend en charge l'édition par lots, la segmentation rapide des phrases, la fusion en un clic et la prévisualisation des paragraphes.

L'interface reste réactive même avec des milliers de sous-titres, minimisant ainsi le temps de montage manuel pour les vidéos longues.

Prise en charge des sous-titres multilingues et bilingues

Pour les cours, les conférences et les entretiens interrégionaux, les utilisateurs ont souvent besoin de générer des sous-titres bilingues ou multilingues.

Après avoir généré les sous-titres dans la langue source, EasySub peut les traduire dans plusieurs langues, comme l'anglais, l'espagnol et le portugais. Il prend également en charge l'exportation bilingue pour la création de versions internationales du contenu.

Alignement chronologique intégré

Le problème le plus fréquent avec les vidéos longues est le désynchronisme croissant des sous-titres vers la fin. Pour y remédier, EasySub intègre un mécanisme de correction de la chronologie. Après la détection, il effectue un réalignement précis entre les sous-titres et la piste audio afin de garantir une synchronisation parfaite des sous-titres tout au long de la vidéo.

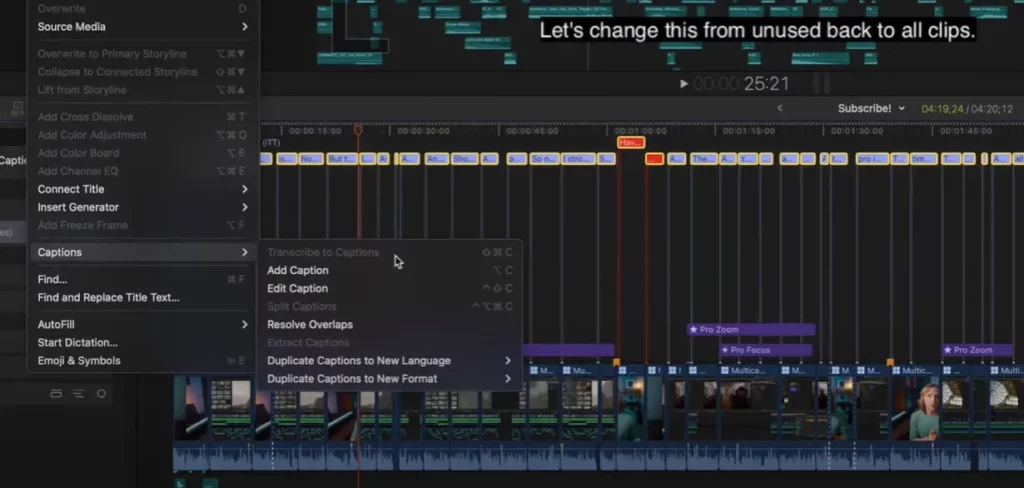

Processus étape par étape pour générer des sous-titres précis pour les vidéos longues

Le principal défi de la création de sous-titres pour les vidéos longues réside dans la maîtrise de processus complexes et sujets aux erreurs. C'est pourquoi un guide clair et pratique, étape par étape, permet aux utilisateurs de comprendre rapidement l'ensemble du processus et de réduire les risques d'erreur. Le processus décrit ci-dessous s'applique aux enregistrements vidéo d'une durée de 1 à 2 heures, voire plus, tels que les cours, les interviews, les réunions et les podcasts.

1. Téléverser des fichiers vidéo (mp4 / mov / mkv / Enregistrements d'écran)

.png)

Téléversez la vidéo sur la plateforme de sous-titrage. Les fichiers vidéo longs étant généralement volumineux, assurez-vous d'avoir une connexion internet stable pour éviter toute interruption. La plupart des logiciels de sous-titrage professionnels prennent en charge les formats courants tels que mp4, mov et mkv, et peuvent également traiter les vidéos issues de Zoom, Teams ou les enregistrements d'écran mobile.

2. Réduction automatique du bruit et détection de la clarté de la parole

Avant la reconnaissance, le système applique une légère réduction du bruit audio et évalue la clarté globale. Cette étape minimise efficacement l'impact du bruit de fond sur les résultats de la reconnaissance. Étant donné que les variations de bruit sont importantes dans les vidéos longues, ce processus améliore la stabilité et la précision des sous-titres suivants.

3. Sélectionnez le modèle de reconnaissance linguistique ou multilingue

Les utilisateurs peuvent choisir le modèle de langue principal en fonction du contenu vidéo. Par exemple : anglais, espagnol, portugais ou mode multilingue. Pour les vidéos de type interview où les intervenants utilisent deux langues, le modèle multilingue assure une reconnaissance fluide et minimise les omissions.

4. Lancer la reconnaissance automatique par IA et générer la segmentation des phrases

L'IA segmente l'audio pour la reconnaissance et génère automatiquement une ébauche de sous-titres, en appliquant des coupures de phrases basées sur le sens et les pauses vocales. Les vidéos plus longues nécessitent une logique de segmentation plus complexe. Les modèles professionnels déterminent automatiquement les sauts de ligne afin de réduire le travail de post-production.

5. Relire les sous-titres, ajuster la chronologie et fusionner les phrases longues

-1024x598.png)

Après la génération, vérifiez rapidement les sous-titres :

- Vérifier la synchronisation de la chronologie

- Fusionner les lignes de sous-titres excessivement courtes

- Supprimez les sauts de phrase inutiles

- Corriger les noms propres, la terminologie ou les termes de propriété.

Les vidéos longues présentent souvent des problèmes de synchronisation : la première moitié est correcte, la seconde est décalée. Les logiciels professionnels proposent des fonctions de correction de la chronologie pour minimiser ces décalages.

6. Exporter au format souhaité : SRT / VTT / MP4 Sous-titres intégrés

Après modification, exportez le fichier de sous-titres. Les formats courants sont les suivants :

- SRT: Le plus universel, compatible avec la plupart des joueurs

- VTTIdéal pour les plateformes web et d'apprentissage

- Sous-titres intégrés MP4Idéal pour la publication directe sur les réseaux sociaux ou les plateformes de cours vidéo.

Si vous publiez sur YouTube, Vimeo ou des plateformes de cours, sélectionnez le format qui répond à leurs exigences spécifiques.

Cas d'utilisation : Qui a réellement besoin de sous-titres IA pour les vidéos longues ?

| Cas d'utilisation | Points de douleur réels des utilisateurs |

|---|---|

| YouTube et les créateurs de contenu éducatif | Les longues vidéos éducatives génèrent un volume considérable de sous-titres, rendant leur production manuelle impraticable. Les créateurs ont besoin d'un calendrier stable et d'une grande précision pour optimiser l'expérience de visionnage. |

| Cours en ligne (1 à 3 heures) | Les cours comportent de nombreux termes techniques, et une segmentation inexacte peut nuire à l'apprentissage. Les formateurs ont besoin de sous-titres rapides et modifiables, ainsi que d'options multilingues. |

| Podcasts et interviews | Les conversations longues s'accompagnent de variations dans le débit de parole et d'un taux d'erreurs de reconnaissance plus élevé. Les créateurs souhaitent des sous-titres complets et rapides pour le montage ou la publication. |

| Enregistrements de réunions Zoom/Teams | Lorsque plusieurs intervenants interviennent simultanément, les outils courants sont sujets aux erreurs. Les utilisateurs ont besoin de sous-titres générés rapidement, consultables et archivables. |

| Conférences universitaires | La densité du vocabulaire académique rend la transcription précise des longues vidéos plus difficile. Les étudiants ont besoin de sous-titres précis pour réviser et organiser leurs notes. |

| Enregistrements audio des audiences / Entretiens d'enquête | Durée de traitement prolongée et exigences de précision strictes. Toute erreur de reconnaissance peut avoir des conséquences sur la documentation ou son interprétation juridique. |

| Documentaires | Les perturbations environnementales complexes affectent facilement les modèles d'IA. Les producteurs ont besoin d'une synchronisation stable et durable du calendrier pour la post-production et la distribution internationale. |

Références de précision pour la génération de sous-titres de vidéos longues

Les performances des différents outils de sous-titrage varient considérablement pour les vidéos longues. Les capacités du modèle, l'efficacité de la réduction du bruit et la logique de segmentation des phrases influent directement sur la qualité finale des sous-titres. Vous trouverez ci-dessous des plages de précision couramment utilisées dans le secteur, servant de référence pour comprendre les performances de génération de sous-titres pour les vidéos longues.

Taux de précision de référence de l'industrie

- Whisper Large-v3Environ 95% (performances constantes dans des environnements multilingues et à faible bruit)

- Outils gratuits courants sur le marchéEnviron 80–90% (plus sensible au bruit de fond et aux accents)

- Sous-titrage humain (transcription manuelle): Approche de 100% (mais coûteux et long)

Bien que ces chiffres ne couvrent pas tous les cas de figure, ils mettent en lumière un point essentiel : obtenir une précision de reconnaissance élevée est plus difficile pour les vidéos longues que pour les courtes. Les vidéos longues présentent des variations de débit de parole plus marquées, un bruit de fond plus complexe et accumulent davantage d’erreurs au fil du temps, ce qui augmente considérablement le temps de post-production.

Pourquoi la précision est plus importante pour les vidéos longues

- Les erreurs s'accumulent avec la longueur de la vidéo, ce qui entraîne une augmentation exponentielle du temps de montage.

- Les variations de qualité audio dans les enregistrements multi-segments entraînent une instabilité de la reconnaissance.

- Les sous-titres de la seconde moitié du film sont plus sujets aux retards ou aux décalages, ce qui nuit à l'expérience du spectateur.

- Les contenus longs tels que les cours, les conférences et les entretiens contiennent souvent de nombreux noms propres, ce qui exige une plus grande précision.

Résultats des tests internes d'EasySub

Pour évaluer les performances dans des scénarios longs, nous avons mené des tests internes utilisant divers documents réels. Les résultats montrent que pour 60 à 90 minutes Dans les vidéos, EasySub atteint une précision globale se rapprocher des modèles leaders du secteur tout en maintenant des performances stables grâce à une terminologie spécialisée et un traitement vocal continu.

FAQ — Sous-titres IA pour les vidéos longues

Q1. Dans quelle mesure les sous-titres générés par l'IA pour les vidéos longues sont-ils précis ?

La précision se situe généralement entre 85% et 95%, selon la qualité audio, l'accentuation des locuteurs, le bruit de fond et le type de vidéo. Les vidéos longues présentent davantage de difficultés que les courtes en raison de leur durée et des variations du débit de parole ; nous recommandons donc de relire les sous-titres après leur génération.

Q2. Quelle est la longueur maximale des vidéos que EasySub peut gérer ?

EasySub prend en charge le traitement de vidéos d'une durée de 1 heure, 2 heures, voire plus, et gère efficacement les fichiers volumineux tels que les enregistrements d'écran, les cours et les réunions. La limite pratique dépend de la taille du fichier et de la vitesse de chargement.

Q3. Combien de temps faut-il pour générer les sous-titres d'une vidéo d'une heure ?

L'opération prend généralement entre 5 et 12 minutes. La durée réelle peut varier en fonction de la charge du serveur, de la complexité audio et des exigences de traitement multilingue.

Q4. Quels formats de fichiers de sous-titres et de vidéos sont pris en charge ?

Les formats vidéo courants incluent mp4, mov, mkv, webm, les fichiers d'enregistrement d'écran, etc. Les formats d'exportation de sous-titres prennent généralement en charge les fichiers SRT, VTT et MP4 avec sous-titres intégrés, répondant ainsi aux exigences de téléchargement des différentes plateformes.

Q5. Une relecture manuelle est-elle nécessaire après la génération ?

Nous recommandons une relecture sommaire, notamment pour la terminologie, les noms propres, les accents marqués et les dialogues à plusieurs interlocuteurs. Si l'IA réduit considérablement la charge de travail, la vérification humaine garantit une plus grande précision et un professionnalisme accru dans le résultat final.

Obtenez des sous-titres précis pour vos longues vidéos

Des sous-titres de qualité améliorent considérablement la lisibilité et le professionnalisme des vidéos longues. Importez votre vidéo pour générer automatiquement les sous-titres, puis relisez-les et exportez-les rapidement selon vos besoins. Idéal pour les enregistrements de cours, les transcriptions de réunions, les interviews et les tutoriels vidéo de longue durée.

Si vous souhaitez améliorer encore la clarté et l'impact de vos contenus vidéo longs, commencez par la génération automatique de sous-titres.

👉Cliquez ici pour un essai gratuit : easyssub.com

Merci d'avoir lu ce blog. N'hésitez pas à nous contacter pour plus de questions ou besoins de personnalisation !