Wenn Videos von wenigen Minuten auf ein bis zwei Stunden anwachsen, steigt der Aufwand für die Untertitelung exponentiell: größere Textmengen müssen erkannt werden, die Sprechgeschwindigkeit variiert deutlich, die Satzstrukturen werden komplexer und Zeitebenen sind anfälliger für Verschiebungen. Daher suchen immer mehr Kreative, Kursentwickler und Podcast-Teams nach einer stabileren und präziseren Lösung – einer Untertitelung. KI-Untertitelgenerator für lange Videos. Es muss nicht nur große Dateien schnell verarbeiten, sondern auch eine perfekte Synchronisation und semantische Kohärenz im gesamten Video gewährleisten. Für Nutzer, die die Zugänglichkeit von Inhalten verbessern, das Seherlebnis optimieren oder Untertitel für mehrsprachige Zielgruppen bereitstellen möchten, geht es bei einem zuverlässigen Workflow zur KI-gestützten Untertitelgenerierung nicht nur um Effizienzsteigerung, sondern auch um die Sicherstellung der Inhaltsqualität.

Inhaltsverzeichnis

Lange Videos benötigen einen spezialisierten KI-Untertitelgenerator

Die Herausforderungen bei der Untertitelung von Langvideos unterscheiden sich grundlegend von denen von Kurzvideos. Erstens ist der Sprachinhalt in Langvideos komplexer: Je länger das Video, desto wahrscheinlicher variieren Sprechtempo, Intonation und Deutlichkeit. Diese ’Sprachdrift“ beeinträchtigt die Genauigkeit der KI-Erkennung direkt. Zweitens enthalten Langvideos oft zahlreiche Hintergrundgeräusche – wie beispielsweise das Umblättern von Seiten in Vorlesungen, Umgebungsgeräusche in Interviews oder Tastaturklicks in Meeting-Aufzeichnungen –, die die Analyse der Sprachwellenformen erschweren. Gleichzeitig ist die Satzstruktur in Langvideos anspruchsvoller zu verarbeiten – die KI muss nicht nur den Inhalt erkennen, sondern auch Satzgrenzen über mehrere Minuten oder sogar Stunden Audiomaterial präzise identifizieren. Hinzu kommt, dass die Audioqualität in Langvideos oft uneinheitlich ist. Quellen wie Zoom, Teams oder Aufzeichnungen aus dem Unterricht können ungleichmäßige Lautstärken oder übermäßige Audiokomprimierung aufweisen, was die Erkennung zusätzlich erschwert.

Daher stoßen gängige Untertitelungstools bei der Verarbeitung von Videos, die länger als eine Stunde sind, häufig auf Probleme wie Stottern, fehlende Wörter, Verzögerungen, fehlerhafte Zeitleistenausrichtung oder gar Abstürze. Nicht alle KI-Untertitelungstools unterstützen Videos, die länger als eine Stunde sind, zuverlässig. Viele Nutzer suchen daher nach Lösungen, die speziell für längere Videos optimiert sind.

Wichtige Faktoren für Nutzer bei einem KI-Untertitelgenerator für lange Videos

1. Genauigkeit der Untertitel

- In langen Videos häufen sich Fehler, was die Kosten für das Korrekturlesen erhöht.

- Akzente, Hintergrundgeräusche, Aufnahmequalität, unterschiedliche Sprechgeschwindigkeiten und mehrere Sprecher beeinflussen die Erkennungsgenauigkeit.

- Die Tools benötigen stärkere Fähigkeiten zur Rauschunterdrückung, Satzsegmentierung und zum Kontextverständnis.

2. Bearbeitungszeit

- Die Nutzer erwarten, dass einstündige Videos innerhalb von 5 bis 20 Minuten transkribiert werden.

- Langsame Verarbeitungsprozesse oder Fehler beeinträchtigen das Benutzererlebnis unmittelbar.

- Stabile Server und effiziente Inferenzfähigkeiten sind von entscheidender Bedeutung.

3. Kompatibilität mit langen Videos

- Kostenlose Tools sind oft auf 10–20 Minuten begrenzt, wodurch das Hochladen längerer Videos fehlschlägt.

- Die Nutzer benötigen Tools, die Videos von 1–3 Stunden oder länger zuverlässig verarbeiten können.

- Während der Verarbeitung traten keine Abstürze oder Datenverluste auf.

4. Zeitliche Ausrichtung

- Bei längeren Videos kommt es am häufigsten zu Verzögerungen oder Vorverlegungen der Untertitel.

- Nutzer befürchten, dass die Untertitel “in der ersten Hälfte korrekt, in der zweiten Hälfte aber fehlerhaft” sind.”

- Mechanismen zur erzwungenen Ausrichtung und Zeitkorrektur verbessern die Synchronisationsqualität.

5. Mehrsprachige Untertitel

- Kurse, Vorlesungen und Interviews erfordern häufig mehrsprachige Untertitel.

- Die Nutzer erwarten eine Übersetzung mit einem Klick und den Export zweisprachiger Untertitel.

- Mehrsprachigkeit ist ein bedeutender Vorteil für Tools zur Erstellung von Langvideos.

6. Einfache Bearbeitung

- Bei langen Videos sind umfangreiche Untertitel erforderlich, was das Korrekturlesen zeitaufwändig macht.

- Die Nutzer benötigen Funktionen wie Stapelverarbeitung, schnelles Aufteilen von Sätzen und Zusammenführen von Zeilen.

- Um die Effizienz der Postproduktion zu steigern, müssen die Editoren stabil und verzögerungsfrei arbeiten.

Wie KI-Untertitelgeneratoren für lange Videos funktionieren

Um Untertitel für ein- bis zweistündige Videos zu generieren, muss die KI einen komplexeren technischen Prozess durchlaufen als bei kürzeren Videos. Die folgenden Schritte gewährleisten, dass die Untertitel nicht nur generiert, sondern auch über die gesamte Videolänge stabil, präzise und synchronisiert bleiben.

a. Audiosegmentierung

Bei der Verarbeitung langer Videos übergibt die KI die gesamte Audiodatei nicht auf einmal an das Modell. Dies würde Erkennungsfehler oder Server-Timeouts aufgrund von Dateigrößenbeschränkungen riskieren. Stattdessen teilt das System die Audiodatei zunächst anhand ihrer semantischen Bedeutung oder Dauer in kleinere Segmente von wenigen Sekunden bis zu mehreren zehn Sekunden auf. Dies gewährleistet eine stabile Ausführung der Erkennungsaufgabe. Die Segmentierung reduziert zudem den Speicherverbrauch und ermöglicht so einen effizienten Betrieb des Modells.

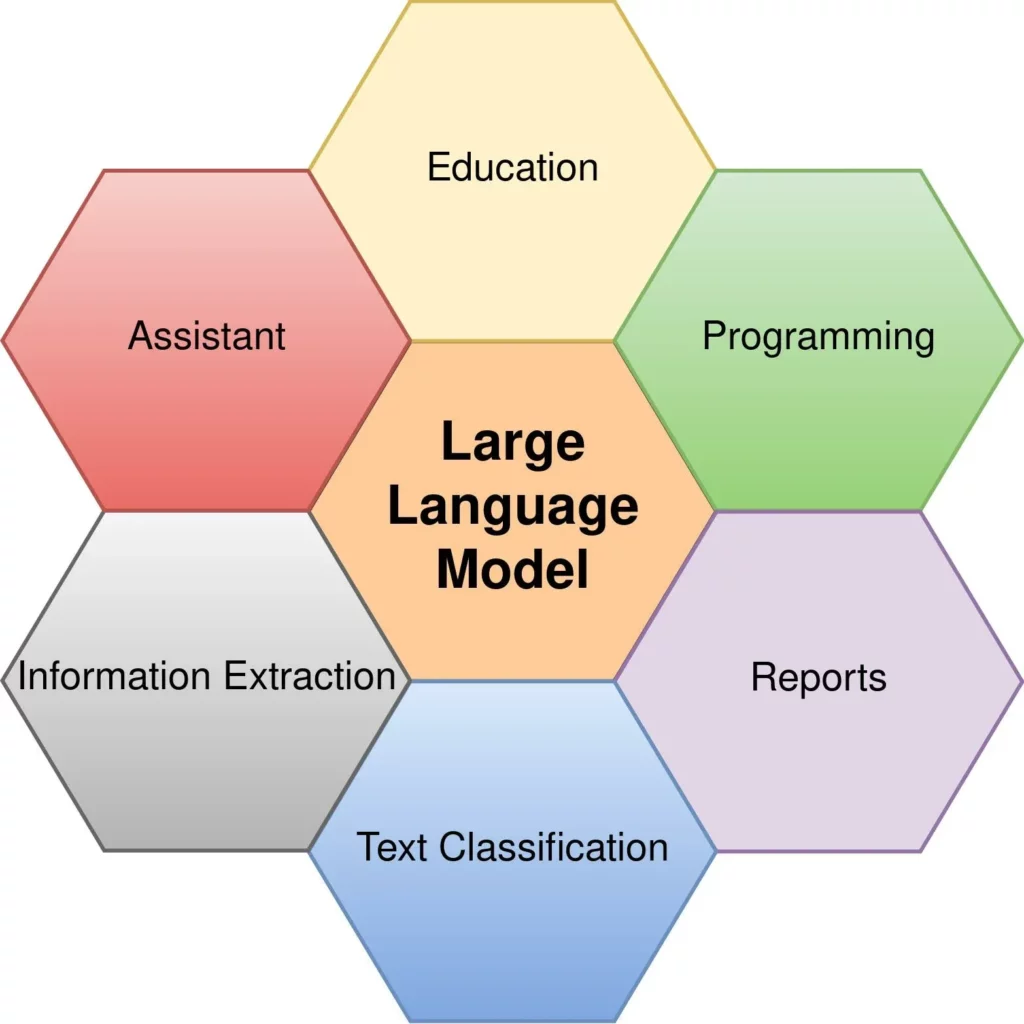

b. Automatisches Spracherkennungsmodell (ASR)

Nach der Audiosegmentierung folgt der Kernschritt der KI: die Umwandlung von Sprache in Text. Zu den branchenüblichen Modellen gehören Transformer, wav2vec 2.0 und Whisper.

- Transformator Bietet eine stabile Leistung in gängigen Sprachen wie Englisch, reagiert aber weiterhin empfindlich auf Akzentvariationen.

- wav2vec 2.0 Es eignet sich hervorragend für Umgebungen mit geringem Geräuschpegel und ist daher ideal für längere Videos wie Vorlesungen und Interviews.

- Flüstern bietet eine überlegene Hintergrundgeräuschunterdrückung und mehrsprachige Unterstützung, was ihm in längeren Videoszenarien einen Vorteil verschafft.

Unterschiedliche Modelle führen bei längeren Videos zu deutlichen Abweichungen in der Erkennungsgenauigkeit. Fortgeschrittenere Modelle bewältigen Details wie Schwankungen der Sprechgeschwindigkeit, Pausen und geringfügiges Rauschen besser.

Untertitel sind kein durchgehender Text, sondern kurze, inhaltlich gegliederte Abschnitte. Die Satzsegmentierung ist bei kurzen Videos relativ einfach, wird aber bei längeren Videos aufgrund von Tonfalländerungen, anhaltender Sprechermüdung und logischen Übergängen schwieriger. Künstliche Intelligenz nutzt Sprechpausen, semantische Strukturen und Wahrscheinlichkeitsmodelle, um Zeilenumbrüche oder Satzzusammenführungen zu erkennen. Eine präzisere Segmentierung reduziert den Aufwand für die Nachbearbeitung.

d. Zwangsausrichtung

Selbst bei fehlerfreier Texterkennung kann es vorkommen, dass Untertitel nicht synchron zum Ton sind. Besonders lange Videos sind anfällig für dieses Problem: Anfangs korrekt, später nicht mehr. Um dem entgegenzuwirken, nutzt die KI eine Technologie zur erzwungenen Synchronisierung, die den erkannten Text Wort für Wort mit der Tonspur abgleicht. Dieser Prozess arbeitet mit Millisekundenpräzision und gewährleistet so eine konsistente Untertitelsynchronisation im gesamten Video.

e. Korrektur des Sprachmodells

Lange Videos weisen eine besondere Eigenschaft auf: starke inhaltliche Bezüge. So kann beispielsweise eine Vorlesung dasselbe Kernkonzept wiederholt behandeln. Um die Kohärenz der Untertitel zu verbessern, setzt KI Sprachmodelle für eine sekundäre Korrektur nach der Erkennung ein. Das Modell bewertet anhand des Kontextes, ob bestimmte Wörter ersetzt, zusammengeführt oder angepasst werden sollten. Dieser Schritt verbessert die Flüssigkeit und Professionalität der Untertitel in längeren Videos deutlich.

EasySub als KI-Untertitelgenerator für lange Videos

Bei der Erstellung von Untertiteln für lange Videos legt EasySub Wert auf Stabilität und Kontrollierbarkeit statt auf reine Geschwindigkeit oder Automatisierung. Die folgenden Funktionen gewährleisten eine gleichbleibende Leistung bei der Verarbeitung von Videos mit einer Länge von 1–3 Stunden und eignen sich daher ideal für umfangreiche Inhalte wie Vorlesungen, Interviews, Podcasts und Tutorials.

Unterstützung für längere Videoverarbeitungszeiten

EasySub verarbeitet zuverlässig lange Videodateien mit einer Länge von 1 Stunde, 2 Stunden oder sogar noch länger. Ob aufgezeichnete Vorlesungen, Besprechungsprotokolle oder ausführliche Interviews – die Erkennung erfolgt nach dem Hochladen kontinuierlich und ohne die üblichen Unterbrechungen oder Timeout-Fehler.

Hohe Verarbeitungsgeschwindigkeit

In den meisten Fällen nutzt EasySub Parallelverarbeitung basierend auf Serverlast- und Modelloptimierungsstrategien.

Ein 60-minütiges Video generiert in der Regel innerhalb von 5–12 Minuten vollständige Untertitel. Lange Videos behalten bei dieser Geschwindigkeit eine hohe Stabilität und Ausgabekonsistenz bei.

Mehrschichtige Optimierung für höhere Genauigkeit

EasySub nutzt für längere Videos verschiedene Erkennungs- und Optimierungsstrategien, darunter mehrsprachige automatische Spracherkennung (ASR), eine sanfte automatische Rauschunterdrückung und ein trainiertes Satzsegmentierungsmodell. Diese Kombination reduziert Hintergrundgeräusche und verbessert die Erkennungsgenauigkeit bei längeren, zusammenhängenden Sprachsequenzen.

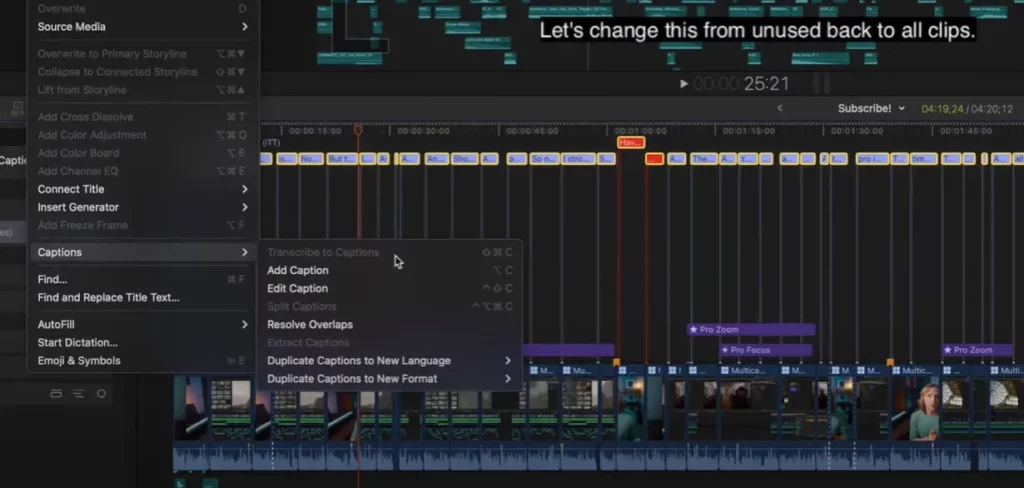

Optimiertes Bearbeitungserlebnis

Untertitel für längere Videos erfordern oft manuelles Korrekturlesen. Der Editor von EasySub unterstützt Stapelverarbeitung, schnelle Satzsegmentierung, Zusammenführen mit einem Klick und Absatzvorschau.

Die Benutzeroberfläche bleibt auch bei Tausenden von Untertiteln reaktionsschnell, wodurch der manuelle Bearbeitungsaufwand für lange Videos minimiert wird.

Mehrsprachige und zweisprachige Untertitelunterstützung

Für Kurse, Vorlesungen und regionsübergreifende Interviews benötigen Nutzer häufig zweisprachige oder mehrsprachige Untertitel.

Nach der Generierung von Untertiteln in der Ausgangssprache kann EasySub diese in mehrere Sprachen wie Englisch, Spanisch und Portugiesisch erweitern. Es unterstützt außerdem den zweisprachigen Export zur Erstellung internationaler Inhaltsversionen.

Integrierte Zeitachsenausrichtung

Das häufigste Problem bei langen Videos ist die zunehmende Asynchronität der Untertitel gegen Ende. Um dies zu verhindern, verfügt EasySub über einen Mechanismus zur Korrektur der Zeitleiste. Nach der Erkennung erfolgt eine präzise Neuausrichtung der Untertitel- und Audiospuren, um eine konsistente Untertitelsynchronität im gesamten Video ohne Abweichungen zu gewährleisten.

Schrittweiser Workflow zur Erstellung präziser Untertitel für lange Videos

Die größte Herausforderung bei der Erstellung von Untertiteln für lange Videos liegt in der Bewältigung komplexer und fehleranfälliger Arbeitsabläufe. Eine klare, praxisorientierte Schritt-für-Schritt-Anleitung hilft Nutzern daher, den gesamten Prozess schnell zu verstehen und Fehler zu reduzieren. Der folgende Workflow eignet sich für Videoaufnahmen mit einer Länge von ein bis zwei Stunden oder länger, wie beispielsweise Vorlesungen, Interviews, Meetings und Podcasts.

1. Videodateien hochladen (mp4 / mov / mkv / Bildschirmaufnahmen)

.png)

Laden Sie das Video auf die Untertitelungsplattform hoch. Lange Videodateien sind in der Regel groß, daher ist eine stabile Internetverbindung wichtig, um Upload-Unterbrechungen zu vermeiden. Die meisten professionellen Untertitelungstools unterstützen gängige Formate wie MP4, MOV und MKV und können auch Videos von Zoom, Teams oder Bildschirmaufnahmen von Mobilgeräten verarbeiten.

2. Automatische Rauschunterdrückung und Sprachverständlichkeitserkennung

Vor der Erkennung wendet das System eine leichte Rauschunterdrückung auf das Audiomaterial an und bewertet die allgemeine Verständlichkeit. Dieser Schritt minimiert effektiv den Einfluss von Hintergrundgeräuschen auf die Erkennungsergebnisse. Da sich die Rauschmuster in längeren Videos verändern, verbessert dieser Prozess die Stabilität und Genauigkeit der nachfolgenden Untertitel.

3. Wählen Sie die Erkennungssprache oder das mehrsprachige Modell aus.

Nutzer können das primäre Sprachmodell anhand des Videoinhalts auswählen. Beispiele hierfür sind Englisch, Spanisch, Portugiesisch oder der mehrsprachige Modus. Bei Videos im Interviewstil, in denen Sprecher zwei Sprachen verwenden, gewährleistet der mehrsprachige Modus eine flüssige Verständlichkeit und minimiert Auslassungen.

4. Automatische KI-Erkennung starten und Satzsegmentierung generieren

Die KI segmentiert den Ton zur Spracherkennung und generiert automatisch einen Untertitelentwurf, wobei Satzumbrüche anhand der semantischen Bedeutung und Sprechpausen eingefügt werden. Längere Videos erfordern eine komplexere Segmentierungslogik. Professionelle Modelle bestimmen Zeilenumbrüche automatisch, um den Nachbearbeitungsaufwand zu reduzieren.

5. Untertitel Korrektur lesen, Zeitleiste anpassen und lange Sätze zusammenfügen

-1024x598.png)

Nach der Generierung sollten Sie die Untertitel kurz überprüfen:

- Überprüfen Sie die Synchronisierung der Zeitleiste.

- Zu kurze Untertitelzeilen zusammenführen

- Überflüssige Satzumbrüche entfernen

- Korrigieren Sie spezifische Substantive, Fachbegriffe oder geschützte Bezeichnungen.

Bei längeren Videos kommt es häufig zu Problemen wie “korrekter erster Teil, fehlerhafter zweiter Teil”. Professionelle Tools bieten Funktionen zur Korrektur der Zeitleiste, um solche Diskrepanzen zu minimieren.

6. Export im gewünschten Format: SRT / VTT / MP4 Eingebettete Untertitel

Nach der Bearbeitung exportieren Sie die Untertiteldatei. Gängige Formate sind:

- SRT: Am weitesten verbreitet, kompatibel mit den meisten Spielern

- VTTIdeal für Webplayer und Lernplattformen

- MP4 Eingebettete UntertitelAm besten geeignet für die direkte Veröffentlichung in sozialen Medien oder Videokurssystemen.

Wenn Sie auf YouTube, Vimeo oder Kursplattformen veröffentlichen, wählen Sie das Format, das deren spezifischen Anforderungen entspricht.

Anwendungsfälle: Wer braucht wirklich KI-Untertitel für lange Videos?

| Anwendungsfall | Reale Probleme der Nutzer |

|---|---|

| YouTube- und Bildungs-Content-Ersteller | Lange Lehrvideos erfordern einen enormen Umfang an Untertiteln, was die manuelle Erstellung unpraktisch macht. Um das Seherlebnis zu optimieren, benötigen die Ersteller einen stabilen Zeitplan und hohe Genauigkeit. |

| Online-Kurse (1–3 Stunden) | Die Kurse enthalten viele Fachbegriffe, und eine ungenaue Segmentierung kann den Lernerfolg beeinträchtigen. Dozenten benötigen daher schnell anpassbare Untertitel und mehrsprachige Optionen. |

| Podcasts und Interviews | Längere Gespräche gehen mit ungleichmäßiger Sprechgeschwindigkeit und häufigeren Erkennungsfehlern einher. Urheber benötigen schnelle, vollständige Untertitel für die Bearbeitung oder Veröffentlichung. |

| Aufzeichnungen von Zoom-/Teams-Meetings | Mehrere Sprecher überlappen sich, wodurch gängige Tools fehleranfällig werden. Nutzer benötigen schnell generierte, durchsuchbare und archivierbare Untertitel. |

| Akademische Vorlesungen | Der komplexe Fachwortschatz erschwert die korrekte Transkription langer Videos. Studierende sind auf präzise Untertitel angewiesen, um ihre Notizen zu wiederholen und zu strukturieren. |

| Gerichtssaal-Audio / Ermittlungsinterviews | Lange Dauer und strenge Genauigkeitsanforderungen. Jeder Erkennungsfehler kann Auswirkungen auf die Dokumentation oder die rechtliche Auslegung haben. |

| Dokumentarfilme | Komplexe Umgebungsgeräusche stören KI-Modelle leicht. Produzenten benötigen eine stabile, langfristige Zeitsynchronisation für die Postproduktion und den internationalen Vertrieb. |

Genauigkeits-Benchmarks für die Untertitelgenerierung von Langvideos

Verschiedene Untertitelungstools weisen bei längeren Videos erhebliche Leistungsunterschiede auf. Modellfähigkeiten, Effektivität der Rauschunterdrückung und Logik der Satzsegmentierung beeinflussen die endgültige Untertitelqualität direkt. Nachfolgend sind branchenübliche Genauigkeitsbereiche aufgeführt, die als Referenz für das Verständnis der Leistungsfähigkeit bei der Untertitelgenerierung für längere Videos dienen.

Branchenübliche Genauigkeitsraten

- Whisper Large-v3: Ungefähr 95% (erbringt konsistente Ergebnisse in mehrsprachigen und rauscharmen Szenarien)

- Gängige kostenlose Tools auf dem MarktUngefähr 80–90% (anfälliger für Hintergrundgeräusche und Akzente)

- Menschliche Untertitelung (Manuelle Transkription)Annäherung an 100% (aber kostspielig und zeitaufwändig)

Diese Zahlen decken zwar nicht alle Szenarien ab, verdeutlichen aber einen wichtigen Punkt: Eine hohe Erkennungsgenauigkeit ist bei langen Videos schwieriger zu erreichen als bei kurzen. Längere Videos weisen stärkere Schwankungen im Sprechtempo, komplexere Hintergrundgeräusche und eine höhere Fehlerquote im Laufe der Zeit auf, was den Nachbearbeitungsaufwand erheblich erhöht.

Warum Genauigkeit bei langen Videos wichtiger ist

- Mit zunehmender Videolänge häufen sich Fehler, wodurch sich die Bearbeitungszeit exponentiell erhöht.

- Schwankungen in der Audioqualität von mehrsegmentigen Aufnahmen führen zu Instabilität bei der Erkennung.

- Die Untertitel in der zweiten Hälfte sind anfälliger für Verzögerungen oder Fehlausrichtungen, was das Seherlebnis beeinträchtigt.

- Längere Inhalte wie Kurse, Vorlesungen und Interviews enthalten oft zahlreiche Eigennamen, was eine höhere Genauigkeit erfordert.

Interne Testergebnisse von EasySub

Um die Leistungsfähigkeit in längeren Szenarien zu bewerten, führten wir interne Tests mit verschiedenen realen Materialien durch. Die Ergebnisse zeigen, dass für 60–90 Minuten EasySub erzielt bei Videos eine hohe Gesamtgenauigkeit. Annäherung an branchenführende Modelle bei gleichzeitiger Aufrechterhaltung einer stabilen Leistung mit Fachterminologie und kontinuierlicher Sprachverarbeitung.

FAQ – KI-Untertitel für lange Videos

Frage 1: Wie genau sind KI-generierte Untertitel für lange Videos?

Die Genauigkeit liegt üblicherweise zwischen 851 TP3T und 951 TP3T, abhängig von der Audioqualität, dem Akzent des Sprechers, Hintergrundgeräuschen und dem Videotyp. Lange Videos stellen aufgrund ihrer längeren Dauer und der variierenden Sprechgeschwindigkeit größere Herausforderungen dar als kurze. Daher empfehlen wir, die Untertitel nach der Erstellung Korrektur zu lesen.

Frage 2: Welche maximale Videolänge kann EasySub verarbeiten?

EasySub unterstützt die Verarbeitung von Videos mit einer Länge von 1 Stunde, 2 Stunden oder sogar länger und verarbeitet zuverlässig große Dateien wie Bildschirmaufnahmen, Vorlesungen und Meetings. Die praktische Obergrenze hängt von der Dateigröße und der Upload-Geschwindigkeit ab.

Frage 3: Wie lange dauert es, Untertitel für ein einstündiges Video zu erstellen?

Die Bearbeitung dauert in der Regel 5–12 Minuten. Die tatsächliche Dauer kann je nach Serverauslastung, Audiokomplexität und Anforderungen an die mehrsprachige Verarbeitung variieren.

Frage 4: Welche Untertitel- und Videodateiformate werden unterstützt?

Gängige Videoformate sind unter anderem mp4, mov, mkv, webm und Bildschirmaufzeichnungsdateien. Untertitel-Exportformate unterstützen typischerweise SRT-, VTT- und MP4-Dateien mit eingebetteten Untertiteln, um den Upload-Anforderungen verschiedener Plattformen gerecht zu werden.

Frage 5: Ist nach der Generierung ein manuelles Korrekturlesen erforderlich?

Wir empfehlen eine grundlegende Überprüfung, insbesondere hinsichtlich Terminologie, Eigennamen, stark akzentuierter Sprache oder Dialogen mit mehreren Sprechern. Obwohl KI den Arbeitsaufwand erheblich reduziert, gewährleistet die menschliche Überprüfung eine höhere Genauigkeit und Professionalität des Endergebnisses.

Erhalten Sie präzise Untertitel für Ihre langen Videos

Hochwertige Untertitel verbessern die Lesbarkeit und Professionalität längerer Videos deutlich. Laden Sie Ihr Video hoch, um automatisch Untertitel zu generieren, und prüfen Sie diese anschließend schnell und exportieren Sie sie bei Bedarf. Ideal für Kursaufzeichnungen, Besprechungsprotokolle, Interviewinhalte und umfangreiche Lehrvideos.

Wenn Sie die Verständlichkeit und Wirkung Ihrer längeren Videoinhalte weiter verbessern möchten, beginnen Sie mit einer automatisierten Untertitelgenerierung.

👉 Klicken Sie hier für eine kostenlose Testversion: easyssub.com

Danke, dass Sie diesen Blog lesen. Bei weiteren Fragen oder Anpassungswünschen können Sie uns gerne kontaktieren!