Wenn die Videolänge von wenigen Minuten auf eine oder zwei Stunden ansteigt, nimmt die Schwierigkeit der Untertitelproduktion exponentiell zu: größere Textmengen, die erkannt werden müssen, erhebliche Schwankungen in der Sprechgeschwindigkeit, komplexere Satzstrukturen und eine größere Anfälligkeit für Zeitverschiebungen. Daher suchen immer mehr Autoren, Kursentwickler und Podcast-Teams nach einer stabileren und genaueren Lösung - einer AI-Untertitelgenerator für lange Videos. Er muss nicht nur große Dateien schnell verarbeiten, sondern auch eine perfekte Synchronisation und semantische Kohärenz im gesamten Video gewährleisten. Für Benutzer, die die Zugänglichkeit von Inhalten verbessern, das Seherlebnis steigern oder Untertitel für mehrsprachige Zielgruppen bereitstellen möchten, ist ein zuverlässiger KI-Workflow zur Untertitelerstellung nicht nur eine Frage der Effizienz, sondern auch der Qualität der Inhalte.

Inhaltsverzeichnis

Lange Videos brauchen einen spezialisierten AI-Untertitelgenerator

Die Herausforderungen bei der Erstellung von Untertiteln für Videos mit langer Laufzeit sind völlig anders als bei Videos mit kurzer Laufzeit. Erstens ist der Sprachinhalt in Langform-Videos komplexer: Je länger die Dauer, desto wahrscheinlicher ist es, dass die Sprechgeschwindigkeit, die Intonation und die Klarheit des Sprechers variieren. Diese ’Sprachabweichung“ wirkt sich direkt auf die KI-Erkennungsgenauigkeit aus. Zweitens enthalten lange Videos oft mehrere Hintergrundgeräusche, wie z. B. Umblättergeräusche in Vorlesungen, Umgebungsgeräusche in Interviews oder Tastaturklicks in Besprechungsaufzeichnungen - all dies erschwert die Analyse von Sprachwellenformen. Gleichzeitig ist die Logik der Satzstruktur in langen Videos schwieriger zu verarbeiten - die KI muss nicht nur den Inhalt erkennen, sondern auch die Satzgrenzen über Dutzende von Minuten oder sogar Stunden von Audioaufnahmen hinweg genau identifizieren. Außerdem ist die Audioqualität in langen Videos oft uneinheitlich. Quellen wie Zoom, Teams oder Klassenzimmeraufnahmen können ungleiche Lautstärken oder eine übermäßige Audiokomprimierung aufweisen, was die Erkennung weiter erschwert.

Daher treten bei der Verarbeitung von Videos, die länger als eine Stunde dauern, häufig Probleme wie Stottern, übersprungene Wörter, Verzögerungen, eine falsche Ausrichtung der Zeitleiste oder sogar Abstürze auf. Nicht alle KI-Tools für Untertitel unterstützen zuverlässig Videos, die länger als eine Stunde sind. Viele Nutzer suchen daher nach Lösungen, die speziell für lange Videos optimiert sind.

Schlüsselfaktoren, auf die Benutzer bei einem AI-Untertitelgenerator für lange Videos achten

1. Genauigkeit des Untertitels

- Bei langen Videos häufen sich die Fehler und die Kosten für das Korrekturlesen steigen.

- Akzente, Hintergrundgeräusche, Aufnahmequalität, unterschiedliche Sprechgeschwindigkeiten und mehrere Sprecher wirken sich alle auf die Erkennungsgenauigkeit aus.

- Die Werkzeuge erfordern eine stärkere Rauschunterdrückung, Satzsegmentierung und kontextbezogene Verständnisfunktionen.

2. Bearbeitungszeit

- Die Nutzer erwarten, dass einstündige Videos innerhalb von 5-20 Minuten transkribiert werden.

- Langsame Verarbeitungen oder Ausfälle beeinträchtigen unmittelbar die Benutzerfreundlichkeit.

- Stabile Server und effiziente Inferenzfunktionen sind von entscheidender Bedeutung.

3. Lange Video-Kompatibilität

- Kostenlose Tools haben oft eine Obergrenze von 10-20 Minuten, so dass lange Videos nicht hochgeladen werden können.

- Die Benutzer benötigen Werkzeuge, die zuverlässig 1-3 Stunden lange Videos oder länger verarbeiten.

- Keine Abstürze oder Inhaltsverluste während der Verarbeitung.

4. Ausrichtung der Zeitachse

- Bei langen Videos kommt es häufig zu Verzögerungen oder Vorschüben bei den Untertiteln.

- Die Nutzer befürchten, dass die Untertitel “in der ersten Hälfte korrekt sind, aber in der zweiten Hälfte nicht mehr stimmen”.”

- Erzwungene Ausrichtung und Zeitlinienkorrekturmechanismen verbessern die Synchronisationsqualität.

5. Mehrsprachige Untertitel

- Kurse, Vorlesungen und Interviews erfordern häufig mehrsprachige Untertitel.

- Die Nutzer erwarten eine Ein-Klick-Übersetzung und einen zweisprachigen Untertitelexport.

- Die Mehrsprachigkeit ist ein wesentlicher Vorteil für Langform-Videotools.

6. Einfaches Editieren

- Bei langen Videos sind die Untertitel sehr umfangreich, was das Korrekturlesen zeitaufwändig macht.

- Die Benutzer benötigen Funktionen wie Stapelbearbeitung, schnelle Satztrennung und Zusammenführung von Zeilen.

- Editoren müssen stabil und verzögerungsfrei arbeiten, um die Effizienz der Postproduktion zu steigern.

Wie AI-Untertitelgeneratoren für lange Videos funktionieren

Um Untertitel für ein ein- bis zweistündiges Video zu erstellen, muss KI einen komplexeren technischen Prozess durchlaufen als bei kürzeren Videos. Die folgenden Schritte stellen sicher, dass die Untertitel nicht nur generiert werden, sondern auch stabil, genau und über die lange Zeitspanne hinweg synchronisiert bleiben.

a. Audio-Segmentierung

Bei der Verarbeitung langer Videos speist AI nicht die gesamte Audiodatei auf einmal in das Modell ein. Dadurch besteht die Gefahr, dass die Erkennung fehlschlägt oder der Server aufgrund von Dateigrößenbeschränkungen Zeitüberschreitungen verursacht. Stattdessen unterteilt das System die Audiodatei zunächst in kleinere Segmente auf der Grundlage der semantischen Bedeutung oder der Dauer, die jeweils zwischen einigen Sekunden und mehreren Dutzend Sekunden liegen. Dies gewährleistet eine stabile Ausführung der Erkennungsaufgabe. Durch die Segmentierung wird auch der Speicherbedarf reduziert, so dass das Modell effizient arbeiten kann.

b. Modell der automatischen Spracherkennung (ASR)

Nach der Audiosegmentierung geht die KI zum wichtigsten Schritt über: der Umwandlung von Sprache in Text. Zu den branchenüblichen Modellen gehören Transformer, wav2vec 2.0 und Whisper.

- Transformator liefert eine stabile Leistung in gängigen Sprachen wie Englisch, reagiert aber empfindlich auf Akzentvariationen.

- wav2vec 2.0 eignet sich hervorragend für rauscharme Umgebungen und damit auch für längere Videos wie Vorträge und Interviews.

- Flüstern bietet eine überragende Behandlung von Hintergrundgeräuschen und mehrsprachige Unterstützung, was ihr einen Vorteil in erweiterten Videoszenarien verschafft.

Die verschiedenen Modelle weisen bei langen Videos deutliche Unterschiede in der Erkennungsgenauigkeit auf. Fortschrittlichere Modelle können Details wie Schwankungen der Sprechgeschwindigkeit, Pausen und geringfügiges Rauschen besser verarbeiten.

Untertitel sind kein fortlaufender Text, sondern kurze, nach Bedeutung gegliederte Segmente. Die Segmentierung von Sätzen ist bei kurzen Videos relativ einfach, wird aber bei langen Videos aufgrund von Änderungen im Tonfall, längerer Sprechermüdigkeit und logischen Übergängen zur Herausforderung. KI stützt sich auf Sprachpausen, semantische Strukturen und probabilistische Modelle, um zu bestimmen, wann Zeilen unterbrochen oder Sätze zusammengefügt werden sollen. Eine genauere Segmentierung verringert den Nachbearbeitungsaufwand.

d. Erzwungene Angleichung

Selbst bei einwandfreier Texterkennung kann es vorkommen, dass die Untertitel nicht mit dem Ton synchronisiert sind. Lange Videos sind besonders anfällig für Probleme mit “am Anfang richtig, später falsch”. Um hier Abhilfe zu schaffen, setzt AI eine Technologie zur Zwangsausrichtung ein, die den erkannten Text Wort für Wort mit der Tonspur abgleicht. Dieser Prozess arbeitet auf die Millisekunde genau und gewährleistet ein konsistentes Timing der Untertitel im gesamten Video.

e. Korrektur des Sprachmodells

Lange Videos haben ein besonderes Merkmal: starke kontextuelle Verbindungen. Zum Beispiel kann ein Vortrag wiederholt dasselbe Kernkonzept behandeln. Um die Kohärenz von Untertiteln zu verbessern, setzt KI Sprachmodelle zur sekundären Korrektur nach der Erkennung ein. Das Modell bewertet, ob bestimmte Wörter ersetzt, zusammengeführt oder kontextabhängig angepasst werden sollten. Dieser Schritt verbessert die Flüssigkeit und Professionalität von langen Videountertiteln erheblich.

EasySub als AI-Untertitelgenerator für lange Videos

Bei der Erstellung von Untertiteln für lange Videos legt EasySub den Schwerpunkt auf Stabilität und Kontrollierbarkeit statt auf Geschwindigkeit oder Automatisierung. Die folgenden Funktionen sorgen für eine gleichbleibende Leistung bei der Verarbeitung von Videos mit einer Dauer von 1 bis 3 Stunden, so dass es sich auch für längere Inhalte wie Vorlesungen, Interviews, Podcasts und Tutorials eignet.

Unterstützung für längere Videobearbeitungszeiträume

EasySub verarbeitet zuverlässig lange Videodateien, die 1 Stunde, 2 Stunden oder noch länger sein können. Ganz gleich, ob aufgezeichnete Vorlesungen, Sitzungsprotokolle oder längere Interviews verarbeitet werden, die Erkennung wird nach dem Hochladen kontinuierlich abgeschlossen, ohne dass es zu Unterbrechungen oder Zeitüberschreitungen kommt.

Hocheffiziente Verarbeitungsgeschwindigkeit

In den meisten Fällen verwendet EasySub eine parallele Verarbeitung auf der Grundlage von Serverlast- und Modelloptimierungsstrategien.

Ein 60-minütiges Video wird in der Regel innerhalb von 5-12 Minuten vollständig untertitelt. Lange Videos behalten bei dieser Geschwindigkeit eine hohe Stabilität und Ausgabekonsistenz.

Mehrschichtige Optimierung für Genauigkeit

Bei langen Videos setzt EasySub mehrere Erkennungs- und Optimierungsstrategien ein, darunter mehrsprachige ASR, leichte automatische Geräuschreduzierung und ein trainiertes Satzsegmentierungsmodell. Diese Kombination reduziert die Störgeräusche im Hintergrund und verbessert die Erkennungsgenauigkeit für längere kontinuierliche Sprache.

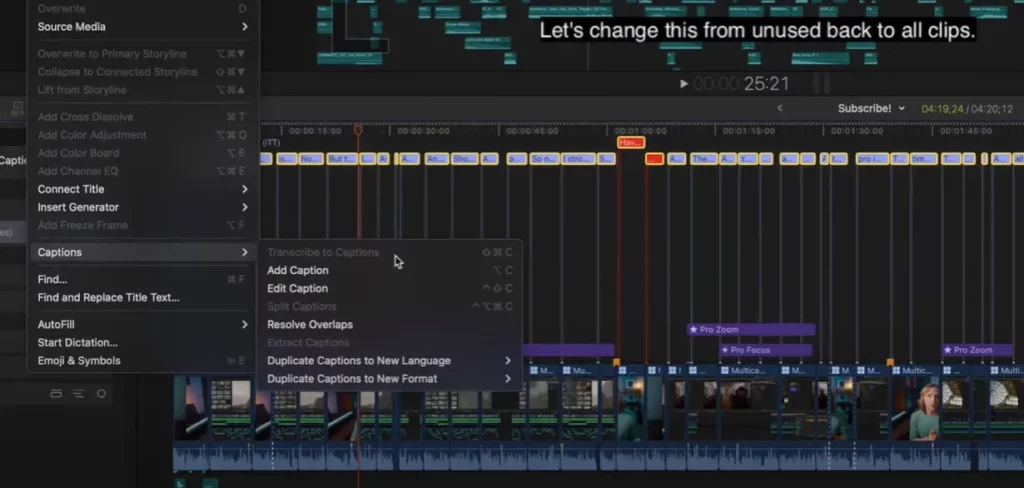

Optimiertes Bearbeitungserlebnis

Lange Videountertitel erfordern oft ein manuelles Korrekturlesen. Der EasySub-Editor unterstützt Stapelbearbeitung, schnelle Satzsegmentierung, Zusammenführung mit einem Klick und Absatzvorschau.

Die Benutzeroberfläche bleibt auch bei Tausenden von Untertiteln reaktionsschnell, was die manuelle Bearbeitungszeit für lange Videos minimiert.

Unterstützung von mehrsprachigen und zweisprachigen Untertiteln

Für Kurse, Vorlesungen und überregionale Interviews müssen die Nutzer oft zweisprachige oder mehrsprachige Untertitel erstellen.

Nach der Erstellung von Untertiteln in der Ausgangssprache kann EasySub diese in mehrere Sprachen wie Englisch, Spanisch und Portugiesisch erweitern. Es unterstützt auch den zweisprachigen Export zur Erstellung internationaler Inhaltsversionen.

Integrierte Zeitleistenausrichtung

Das häufigste Problem bei langen Videos ist, dass die Untertitel zum Ende hin zunehmend aus dem Takt geraten. Um dies zu verhindern, verfügt EasySub über einen Mechanismus zur Korrektur der Zeitachse. Nach der Erkennung führt es eine präzise Neuausrichtung zwischen Untertiteln und Audiospuren durch, um ein konsistentes Untertitel-Timing über das gesamte Video hinweg zu gewährleisten, ohne abzudriften.

Schritt-für-Schritt-Arbeitsablauf für die Generierung präziser Untertitel für lange Videos

Die größte Herausforderung bei der Erstellung von Untertiteln für lange Videos ist die Navigation durch komplexe, fehleranfällige Arbeitsabläufe. Daher hilft eine klare, umsetzbare Schritt-für-Schritt-Anleitung den Benutzern, den gesamten Prozess schnell zu erfassen und die Fehlerquote zu reduzieren. Der folgende Arbeitsablauf gilt für Videoaufnahmen, die 1 bis 2 Stunden oder länger dauern, wie z. B. Vorlesungen, Interviews, Besprechungen und Podcasts.

1. Hochladen von Videodateien (mp4 / mov / mkv / Bildschirmaufzeichnungen)

.png)

Laden Sie das Video auf die Untertitelungsplattform hoch. Lange Videodateien sind in der Regel groß. Sorgen Sie daher für eine stabile Internetverbindung, um Unterbrechungen beim Hochladen zu vermeiden. Die meisten professionellen Untertitelungstools unterstützen gängige Formate wie mp4, mov und mkv und können auch Videos von Zoom, Teams oder mobile Bildschirmaufnahmen verarbeiten.

2. Automatische Rauschunterdrückung und Erkennung der Sprachklarheit

Vor der Erkennung wendet das System eine leichte Rauschunterdrückung auf das Audiomaterial an und bewertet die Gesamtklarheit. Durch diesen Schritt werden die Auswirkungen von Hintergrundgeräuschen auf die Erkennungsergebnisse wirksam minimiert. Da die Rauschmuster in langen Videos variieren, verbessert dieser Prozess die Stabilität und Genauigkeit der nachfolgenden Untertitel.

3. Erkennungssprache oder mehrsprachiges Modell auswählen

Die Benutzer können das primäre Sprachmodell auf der Grundlage des Videoinhalts auswählen. Zum Beispiel: Englisch, Spanisch, Portugiesisch oder mehrsprachiger Modus. Bei Videos im Interviewstil, in denen Sprecher zwei Sprachen mischen, sorgt das mehrsprachige Modell für eine flüssige Erkennung und minimiert Auslassungen.

4. Automatische KI-Erkennung initiieren und Satzsegmentierung generieren

Die KI segmentiert das Audiomaterial für die Erkennung und erstellt automatisch einen Untertitelentwurf, wobei Satzumbrüche auf der Grundlage der semantischen Bedeutung und der Sprechpausen angewendet werden. Längere Videos erfordern eine komplexere Segmentierungslogik. Professionelle Modelle bestimmen automatisch Zeilenumbrüche, um den Arbeitsaufwand für die Nachbearbeitung zu reduzieren.

5. Korrekturlesen von Untertiteln, Anpassen der Zeitleiste und Zusammenführen langer Sätze

-1024x598.png)

Überprüfen Sie nach der Erzeugung schnell die Untertitel:

- Synchronisierung der Zeitleiste überprüfen

- Übermäßig kurze Untertitelzeilen zusammenführen

- Unnötige Satzumbrüche korrigieren

- Bestimmte Substantive, Terminologie oder geschützte Begriffe korrigieren

Bei langen Videos tritt häufig das Problem auf, dass die erste Hälfte korrekt ist und die zweite Hälfte falsch ausgerichtet. Professionelle Tools bieten Funktionen zur Korrektur der Zeitleiste, um solche Diskrepanzen zu minimieren.

6. Export im gewünschten Format: SRT / VTT / MP4 Eingebettete Untertitel

Nach der Bearbeitung exportieren Sie die Untertiteldatei. Gängige Formate sind:

- SRT: Sehr universell, kompatibel mit den meisten Playern

- VTT: Ideal für Webplayer und Lernplattformen

- MP4 eingebettete Untertitel: Am besten geeignet für die direkte Veröffentlichung in sozialen Medien oder Videokurssystemen

Wenn Sie auf YouTube, Vimeo oder Kursplattformen veröffentlichen, wählen Sie das Format, das den jeweiligen Anforderungen entspricht.

Anwendungsfälle: Wer braucht wirklich KI-Untertitel für lange Videos?

| Anwendungsfall | Echte Benutzer-Schmerzpunkte |

|---|---|

| YouTube und Bildungsschaffende | Lange Lehrvideos haben ein großes Volumen an Untertiteln, was eine manuelle Produktion unpraktisch macht. Um das Seherlebnis zu verbessern, benötigen die Produzenten eine stabile Zeitleiste und hohe Genauigkeit. |

| Online-Kurse (1-3 Stunden) | Kurse enthalten viele Fachbegriffe, und eine ungenaue Segmentierung kann das Lernen beeinträchtigen. Lehrkräfte benötigen schnelle, editierbare Untertitel und mehrsprachige Optionen. |

| Podcasts und Interviews | Lange Unterhaltungen gehen mit einer uneinheitlichen Sprachgeschwindigkeit und höheren Erkennungsfehlern einher. Ersteller wollen schnelle Volltext-Untertitel für die Bearbeitung oder Veröffentlichung. |

| Zoom / Teams Meeting-Aufzeichnungen | Mehrere Sprecher überschneiden sich, so dass gemeinsame Tools fehleranfällig sind. Die Benutzer benötigen schnell erstellte, durchsuchbare und archivierbare Untertitel. |

| Akademische Vorlesungen | Ein umfangreiches akademisches Vokabular erschwert die genaue Transkription langer Videos. Die Schüler sind auf genaue Untertitel angewiesen, um ihre Notizen zu überprüfen und zu organisieren. |

| Audios aus dem Gerichtssaal / Investigative Interviews | Lange Dauer und strenge Genauigkeitsanforderungen. Jeder Erkennungsfehler kann sich auf die Dokumentation oder die rechtliche Auslegung auswirken. |

| Dokumentarfilme | Komplexe Umgebungsgeräusche stören die KI-Modelle leicht. Produzenten benötigen für die Postproduktion und den internationalen Vertrieb eine stabile Synchronisierung der Zeitachse über lange Zeiträume. |

Genauigkeits-Benchmarks für die Generierung von Untertiteln für lange Videos

Verschiedene Untertitel-Tools weisen in langen Videoszenarien erhebliche Leistungsunterschiede auf. Die Modellfähigkeiten, die Wirksamkeit der Rauschunterdrückung und die Logik der Satzsegmentierung wirken sich alle direkt auf die endgültige Untertitelqualität aus. Nachfolgend sind die in der Branche üblichen Genauigkeitsbereiche aufgeführt, die als Referenz für das Verständnis der Leistung bei der Erstellung von Untertiteln für Langform-Videos dienen.

Industrie-Referenz-Genauigkeitsraten

- Whisper Large-v3: Ca. 95% (gleichbleibende Leistung in mehrsprachigen und rauscharmen Szenarien)

- Gemeinsame kostenlose Tools auf dem Markt: Ungefähr 80-90% (anfälliger für Hintergrundgeräusche und Akzente)

- Menschliche Untertitelung (manuelle Transkription): Annäherung an 100% (aber kostspielig und zeitaufwendig)

Diese Zahlen decken zwar nicht alle Szenarien ab, sie verdeutlichen jedoch eine wichtige Tatsache: Eine hohe Erkennungsgenauigkeit zu erreichen, ist bei langen Videos schwieriger als bei kurzen Videos. Längere Videos weisen ausgeprägtere Schwankungen in der Sprechgeschwindigkeit und komplexere Hintergrundgeräusche auf und akkumulieren im Laufe der Zeit mehr Fehler, was die Nachbearbeitungszeit erheblich verlängert.

Warum die Genauigkeit bei langen Videos wichtiger ist

- Mit zunehmender Videolänge häufen sich die Fehler, wodurch die Bearbeitungszeit exponentiell ansteigt.

- Schwankungen in der Audioqualität bei Aufnahmen mit mehreren Segmenten führen zu einer instabilen Erkennung.

- Die Untertitel in der zweiten Hälfte sind anfälliger für Verzögerungen oder eine falsche Ausrichtung, was das Seherlebnis beeinträchtigt.

- Lange Inhalte wie Kurse, Vorträge und Interviews enthalten oft zahlreiche Eigennamen, was eine höhere Genauigkeit erfordert.

Interne Testergebnisse von EasySub

Um die Leistung in Langform-Szenarien zu bewerten, haben wir interne Tests mit verschiedenen realen Materialien durchgeführt. Die Ergebnisse zeigen, dass für 60-90 Minuten Videos, erreicht EasySub eine Gesamtgenauigkeit Annäherung an die branchenführenden Modelle bei gleichbleibender Leistung mit spezialisierter Terminologie und kontinuierlicher Sprachverarbeitung.

FAQ - AI Untertitel für lange Videos

Q1. Wie genau sind KI-generierte Untertitel für lange Videos?

Die Genauigkeit liegt in der Regel zwischen 85% und 95%, je nach Audioqualität, Sprecherakzent, Hintergrundgeräuschen und Videotyp. Lange Videos stellen aufgrund der längeren Dauer und der unterschiedlichen Sprechgeschwindigkeit eine größere Herausforderung dar als kurze, daher empfehlen wir, die Untertitel nach der Erstellung zu überprüfen.

Q2. Was ist die maximale Videolänge, die EasySub verarbeiten kann?

EasySub unterstützt die Verarbeitung von Videos mit einer Dauer von 1 Stunde, 2 Stunden oder sogar länger und verarbeitet zuverlässig große Dateien wie Bildschirmaufzeichnungen, Vorlesungen und Meetings. Die praktische Obergrenze hängt von der Dateigröße und der Upload-Geschwindigkeit ab.

Q3. Wie lange dauert es, Untertitel für ein einstündiges Video zu erstellen?

In der Regel innerhalb von 5-12 Minuten abgeschlossen. Die tatsächliche Dauer kann je nach Serverauslastung, Audiokomplexität und mehrsprachigen Verarbeitungsanforderungen variieren.

Q4. Welche Untertitel- und Videodateiformate werden unterstützt?

Zu den gängigen Videoformaten gehören mp4, mov, mkv, webm, Bildschirmaufzeichnungsdateien usw. Die Exportformate für Untertitel unterstützen in der Regel SRT-, VTT- und MP4-Dateien mit eingebetteten Untertiteln, um die Anforderungen verschiedener Plattformen zu erfüllen.

Q5. Ist ein manuelles Korrekturlesen nach der Erstellung erforderlich?

Wir empfehlen, eine grundlegende Überprüfung durchzuführen, insbesondere bei Terminologie, Eigennamen, stark akzentuierter Sprache oder Dialogen mit mehreren Sprechern. Während die KI den Arbeitsaufwand erheblich reduziert, sorgt die menschliche Überprüfung für mehr Genauigkeit und Professionalität in der Endausgabe.

Präzise Untertitel für Ihre langen Videos

Hochwertige Untertitel verbessern die Lesbarkeit und Professionalität von langen Videos erheblich. Laden Sie Ihr Video hoch, um automatisch Untertitel zu generieren, die Sie dann schnell korrigieren und bei Bedarf exportieren können. Ideal für Kursaufzeichnungen, Sitzungsprotokolle, Interviewinhalte und lange Lehrvideos.

Wenn Sie die Klarheit und Wirkung Ihrer langen Videoinhalte weiter verbessern möchten, sollten Sie mit einer automatischen Untertitelerstellung beginnen.

👉 Klicken Sie hier für eine kostenlose Testversion: easyssub.com

Danke, dass Sie diesen Blog lesen. Bei weiteren Fragen oder Anpassungswünschen können Sie uns gerne kontaktieren!